Search console robots.txt tester

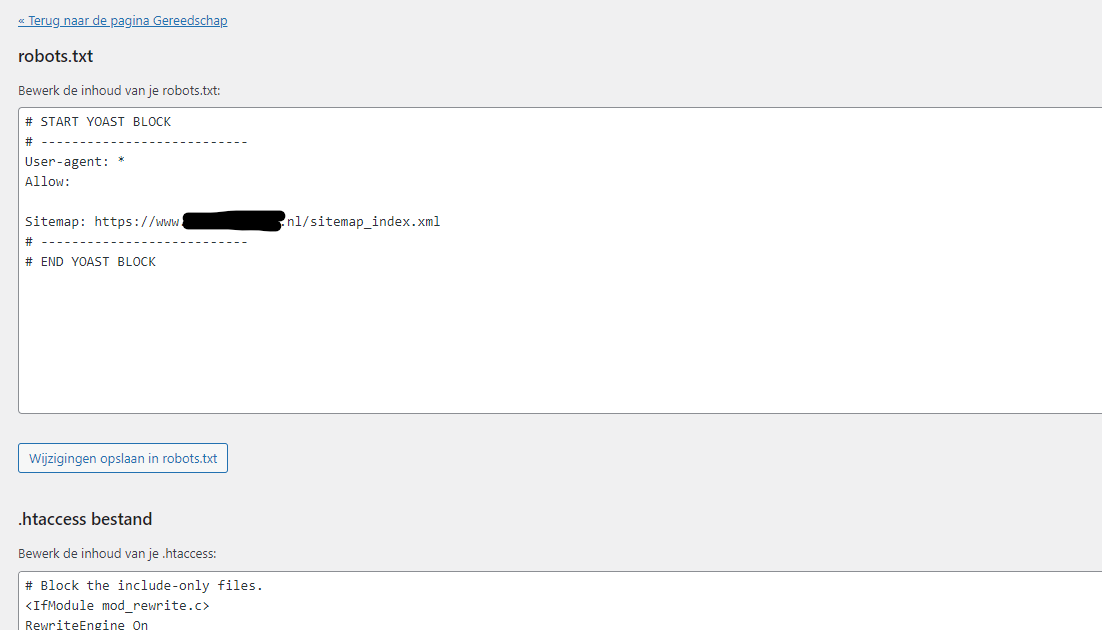

Citaat van Nunzio op 19 maart 2023, 10:04Nu ben ik even nieuwsgierig, ik kreeg een melding van google dat er problemen met indexering waren. Dit had te maken met robots.txt. Waarbij in yoast het robots.txt .bestand, zoals in onderstaande afbeelding, op “Disallowed” stond hetgeen betekent dat google de sitemap niet mag indexeren.

Vind ik raar dat yoast dit automatisch doet, want heb dit bestand niet aangemaakt. Nu heb ik het op “Allowed” gezet, want volgens mij is mijn site dan toch moeilijker te indexeren hierdoor, aangezien de sitemap mijn wegwijzer van mijn site is. Ik hoop dat ik het goed heb gedaan, of kun je de robot.txt beter helemaal weghalen?

Nu ben ik even nieuwsgierig, ik kreeg een melding van google dat er problemen met indexering waren. Dit had te maken met robots.txt. Waarbij in yoast het robots.txt .bestand, zoals in onderstaande afbeelding, op “Disallowed” stond hetgeen betekent dat google de sitemap niet mag indexeren.

Vind ik raar dat yoast dit automatisch doet, want heb dit bestand niet aangemaakt. Nu heb ik het op “Allowed” gezet, want volgens mij is mijn site dan toch moeilijker te indexeren hierdoor, aangezien de sitemap mijn wegwijzer van mijn site is. Ik hoop dat ik het goed heb gedaan, of kun je de robot.txt beter helemaal weghalen?

Citaat van Yannick Schouppe op 19 maart 2023, 11:41Yoast zet ze correct hoor, ik leg even uit:

“Disallow: “(met helemaal niets erachter) is hetzelfde als “Allow: /“. Je kan de robots.txt als volgt lezen:

- Alle user-agents (* dus alle crawlers) hebben niets disallowed (indien Disallow: ) en mogen alles indexeren

- Of alle user-agents mogen alles indexeren (indien Allow: /)

Komt op zelfde neer, heeft enkel iets te maken met compatibiliteit van andere, minder bekende bots en crawlers.

Dus je moet jouw robots.txt nog aanpassen naar “Allow: /” want die / is belangrijk in dit geval.

Verder is Sitemap: {url} enkel een indicatie van de locatie van de sitemap en heeft die allow/disallow daar niets mee te maken. Aparte regel, nieuw command, dus gewoon zo houden.

Nu, er is ook nog zoiets als de meta noindex (https://developers.google.com/search/docs/crawling-indexing/block-indexing) maar dat is op pagina-niveau en lectuur voor later 🙂

Yoast zet ze correct hoor, ik leg even uit:

“Disallow: “(met helemaal niets erachter) is hetzelfde als “Allow: /“. Je kan de robots.txt als volgt lezen:

- Alle user-agents (* dus alle crawlers) hebben niets disallowed (indien Disallow: ) en mogen alles indexeren

- Of alle user-agents mogen alles indexeren (indien Allow: /)

Komt op zelfde neer, heeft enkel iets te maken met compatibiliteit van andere, minder bekende bots en crawlers.

Dus je moet jouw robots.txt nog aanpassen naar “Allow: /” want die / is belangrijk in dit geval.

Verder is Sitemap: {url} enkel een indicatie van de locatie van de sitemap en heeft die allow/disallow daar niets mee te maken. Aparte regel, nieuw command, dus gewoon zo houden.

Nu, er is ook nog zoiets als de meta noindex (https://developers.google.com/search/docs/crawling-indexing/block-indexing) maar dat is op pagina-niveau en lectuur voor later 🙂

Citaat van Yannick Schouppe op 19 maart 2023, 18:36Gebruik je de link tracking van de AH plugin? Dan worden die affiliate links omgezet naar een redirect in de vorm van https://jouwdomein.nl/ah-redirect?etcetcetc.

Voor Google en bijvoorbeeld Ubersuggest lijkt dat dan in eerste instantie een interne link te zijn die moet gecrawled en geindexeerd worden (omdat we alles toelaten in robots.txt), maar plots is er geen content want je wordt doorgestuurd naar een andere website. Dat verwart de tools blijkbaar enorm (geen idee waarom).

Je kan dit controleren door in search console linkermenu naar Indexering -> Pagina’s te gaan en vervolgens te klikken op de “Geblokkeerd door robots.txt” sectie. Als dat allemaal redirects zijn, is er niets aan de hand. En anders moeten we ff verder kijken

Gebruik je de link tracking van de AH plugin? Dan worden die affiliate links omgezet naar een redirect in de vorm van https://jouwdomein.nl/ah-redirect?etcetcetc.

Voor Google en bijvoorbeeld Ubersuggest lijkt dat dan in eerste instantie een interne link te zijn die moet gecrawled en geindexeerd worden (omdat we alles toelaten in robots.txt), maar plots is er geen content want je wordt doorgestuurd naar een andere website. Dat verwart de tools blijkbaar enorm (geen idee waarom).

Je kan dit controleren door in search console linkermenu naar Indexering -> Pagina’s te gaan en vervolgens te klikken op de “Geblokkeerd door robots.txt” sectie. Als dat allemaal redirects zijn, is er niets aan de hand. En anders moeten we ff verder kijken

Citaat van Yannick Schouppe op 23 maart 2023, 14:30Citaat van samuel op 23 maart 2023, 14:12@skoepken zou ik je ergens kunnen pm’en? Ik had een vraag m.b.t. een eerder topic.

Sure, stuur maar mailtje naar skoepken@gmail.com

Citaat van samuel op 23 maart 2023, 14:12@skoepken zou ik je ergens kunnen pm’en? Ik had een vraag m.b.t. een eerder topic.

Sure, stuur maar mailtje naar skoepken@gmail.com